AI PC是噱头还是更快的马车?

2023年以来,所有人都知道AI非常的热、非常的牛、非常的神,生成的文章辞藻华丽、写的报告面面俱到,毫不谦虚地说,打败80%甚至更多的人类。至于文生图、作曲,甚至是视频,都常有令人惊艳的作品。吹爆再吹爆,无需赘述……

对于设计师、文案策划等职业,生成式AI确实已经帮助他们提高了迸发创意的速度,至少不必万丈高楼平地起了。由于效率太高,这些岗位中的部分人可能反而要面对失业的烦恼。但对于普通人,AI除了猎奇,OpenAI、SD等时髦玩意儿好像对工作也没啥实质性的帮助——毕竟平时不需要写什么四平八稳的文章,更不需要吟诗作赋,而且见多了AI的输出,也实在觉得多是些正确的废话,有用,但也没啥大用。

所以,当某手机厂商说以后不生产“传统手机”的时候,大家嗤之以鼻。当AI PC概念出现的时候,也难免觉得是营销噱头。但是,当我在2024英特尔商用客户端 AI PC产品发布会的展区走了一圈之后,我发现AI比我想象中的更有用。是的,有用,不需要技惊四座,但,很有用。

端侧AI的本地化落地带来根本性的体验变化

既然是商用PC,那就离不开生产力工具属性。如果不买最新的硬件,玩不转最新的软件版本,很容易在鄙视链中打上“应用水平低下”的标签。就拿Excel为例吧,最早接触Excel的时候,对效率的理解是会用公式,自动进行一些计算等。再然后,是宏代码,自动执行数据的筛选、排序、导出等等,但这个难度还是比较大的。前几年呢,又似乎流行起了Python,不去学一下那都不配谈数据处理了。在言必称数据可视化的当下,多数Excel用户的真实情况是尝试陌生的公式都需要临时百度一下教程,现学现用,稍复杂的操作可能要屡败屡试。

那PC前面加上“AI”,或者装上某个AI助理,就可以赶时髦了吗?我实际体验之后,确定AI PC绝非如此浅薄。在AI PC上,有个专门做Office插件的公司叫ExtendOffice,就很好地解决了Excel用起来磕磕绊绊的痛点:你只要说出你的意图,AI助手马上直接在Excel表格上进行操作,譬如币值转换,甚至加密某一列数据。不需要去琢磨脑海里的需求到底需要对应哪个公式或者功能才可以实现,不用去查找教程,也跳过了step by step的学习,AI助手当场就处理完了。

这就体现了AI PC一个特别关键的卖点:本地化,且在此基础上,可以嵌入工作流程,直接参与处理。我们中国人特别热爱学习,总说“授人以鱼不如授人以渔”,但“渔”的学习曲线太长了。在AI PC里,鱼和渔可以同时获得,因为渔夫(AI助手)随时都在你眼前,更不要说它还可以当厨师、当秘书。

而且,刚才说的“嵌入”并不局限于某一个操作环节(类似于刚才说的给Excel增加某一列数据、公式),而是可以生成一个多步骤的、跨软件的操作。这也体现了大语言模型的优势:可以接受较长的输入并理解、分拆。譬如,我们完全可以对AI PC说:帮我将电脑静音,然后打开上次阅读的文档,并把它发送给某某邮箱。需要强调的是,以目前的演示,不需要指定准确的文档名,模糊的指示是可以理解的。还有一个让我暗暗叫好的操作是批量修改文件名。在Windows下批量修改文件名是需要一些小技巧的,而且,只能改成有规律的文件名(数字、字母后缀)等,但在AI助手的帮助下,我们可以让文件名更有个性:分别加上相关客户的名字、不同的风格类型等等。这事说起来简单,但其实需要挨个查看文件、提取关键信息,甚至根据自我理解去描述一些抽象的信息,然后挨个编写新的文件名——过程非常琐碎,文件多了就很费时间,但有了AI助手,这就是一句话的事。理解较长的上下文、多模态输入等等,这些都必须依赖大语言模型的能力,但其实是在本地运行的,而非借助云端的推理能力。讲真,应该没有人会认为整理文件名这种本地文件系统的操作还需要去云端绕一圈吧?从端到云之间隐藏的各种断点确实限制了我们的想象力,因此,AI PC的这些本地操作真的打开了我的思路。

相对于大家早期较为熟悉的基于云端的AI工具,本地化还带来了很多显而易见的好处。譬如,断网的情况下,也是可以完成自然语言的处理和其他的操作。这对于那些曾经重度依赖大模型能力,且遭遇过服务故障的早期大模型用户而言,“天塌了”就是痛点。更不要说坐飞机之类的无网络场景了,保持连续的可用性是一个很朴素的需求。

本地部署还可以解决数据安全问题。大模型爆火之初就屡屡传出某某公司不慎泄露数据的新闻。没办法,用ChatGPT做简报、检查代码等等确实很香啊,但前提是得把文档上传到云端。这就导致许多企业一刀切禁止员工使用ChatGPT。后来的事情就是许多企业选择利用开源大模型和内部数据训练、微调私有的大模型,并部署在自有的服务器或云主机上。更进一步的,现在我们看到规模 200 亿参数的大模型可以部署在基于酷睿 Ultra 处理器的 AI PC 上。。

这种部署在AI PC上的大模型已经涉及教育、法律、医学等多个垂直领域,可以生成包括知识图谱、合同、法律意见等。譬如,将案情输入中科创达的魔方智能法务助手,就可以进行案情分析,查找相关的法律条文,撰写法律文书等。在这个场景中,很显然案情的隐私是应该绝对保证的,律师不敢将这种文档传输到云端处理。医生也有类似的约束,基于病例、基因数据等进行课题研究,如果能够在PC上做基因靶点、药理分析等,就不必采购服务器或者部署私有云了。

顺便一提的是,AI PC上的大模型还让训练变得比想象中要简单,把本地你能看到的文件“喂”给AI助理之类的就可以了。这就解决了以往聊天机器人那种活只干了一半的“正确的废话”。譬如,通过AI生成一个报价邮件模板是很轻松的,但是,一般来说价格这种关键信息,机器人不懂那是很正常的事情,所以需要人工进行完善。如果找一个人类来处理这种事情,那提前做一份价格表是合理要求吧?报价表、FAQ等都是属于需要总结提炼的工作,然后才能更有效率地培训新人——这是传统观念。本地的AI可以让这个事情变得很简单:让它去读Outlook邮箱就好了,片刻之后它自己就从历史邮件中“学”到对应的报价。相应生成的邮件就不仅是模版级了,而是要素完善的,留给我们做的就只剩确认AI给的结果是否正确。而且这种学习成果是可以继承下来的。

三大AI引擎撑起本地大模型

信息时代,我们已经经历了几次重大的科技变革。首先是个人电脑的普及,然后是互联网的普及,再就是移动互联网。现在我们正在面对的是AI 对生产力的赋能甚至重构。我们今天讲的AI不是在数据中心里做训练或者推理的大规模集群,而是手边的PC。AIGC、视频制作等面向内容创作者的应用已经不断给予大众诸多震撼了。现在我们进一步看到的是AI PC已经可以实实在在的提升普通白领的工作效率:处理琐碎事务,做简报、写邮件、查找法条等等,并且无缝衔接式地补齐我们的一些技能短板,类似于应用我们原本并不熟悉的的Excel功能、制作原以为高大上的知识图谱,诸如此类。这一切当然不仅仅依赖于大语言模型的“智能涌现”,也需要足够强大的性能以支撑本地部署。

我们多次提到的大模型的“本地部署”,都离不开端侧强劲的AI算力。所谓的AI PC,依靠的是酷睿Ultra处理器强悍的CPU+GPU+NPU三大AI引擎,其算力足够支持200亿参数的大语言模型在本地运行推理过程,至于插图级的文生图为代表的AIGC应用相对而言倒是小菜一碟了。

CPU快速响应:CPU可以用来运行传统的、多样化的工作负载,并实现低延迟。酷睿Ultra采用先进的Intel 4制造工艺,可以让笔记本电脑拥有多达16个核心22个线程,睿频可高达5.1GHz。

GPU高吞吐量:GPU非常适合需要并行吞吐量的大型工作负载。酷睿Ultra 标配Arc GPU核显,酷睿Ultra 7 165H包含8个Xe-LPG 核心(128 个矢量引擎),酷睿Ultra5 125H包含7个。而且,这一代核显还支持AV1硬编码,可以更快速地输出高质量、高压缩率的视频。凭借领先的编解码能力,Arc GPU确实在视频剪辑行业积累的良好的口碑。随着矢量引擎能力的大幅度提升,大量内容创作ISV的演示了基于AI PC的更高效率的智能抠像、插帧等功能。

NPU优异能效:酷睿Ultra处理器全新引入的NPU(神经处理单元)能够以低功耗处理持续存在、频繁使用的AI工作负载,以确保高能效。譬如,火绒演示了利用NPU算力接管以往由CPU和GPU承担的病毒扫描等工作,虽然速度较调用GPU略低,但能耗有明显的优势,特别适合安全这种后台操作。我们已经很熟悉的视频会议中常用的美颜、背景更换、自动居中等操作,也可以交给NPU运行。NPU也完全有能力仅凭一己之力运行轻量级的大语言模型,例如TinyLlama 1.1,足以满足聊天机器人、智能助手、智能运维等连续性的业务需求,而将CPU和GPU的资源留给其他业务。

针对商用AI PC,英特尔还推出了基于英特尔酷睿Ultra的vPro平台,将 AI和商用平台的生产力、安全性、可管理性和稳定性有机结合。博通展示的基于vPro的AI PC智能化管理将传统的资产管理从被动变为主动:以往只能看到设备是否“还在”、“能用”,补丁升级等操作也是计划内的;而AI加持的vPro可以自主分析设备的运行,从中发现隐患并自动匹配相应的补丁包、向运维人员推送建议等。贝锐向日葵有一个AI智能远控报告方案,对PC的远程监控不再仅仅是录屏、截屏,而是可以自动、实时地识别和生成电脑的远程工作记录,包括标记一些敏感操作,如删除文件、输入特定的指令等。这也明显减轻了运维人员检查、回溯记录的工作量。

未来已来:数以百计的ISV实际业务落地

亨利福特曾经这样评价汽车的发明:“如果你问你的顾客需要什么,他们会说需要一辆更快的马车。”

“更快的马车”是一种消费陷阱,认为AI手机、AI PC只是噱头的人们可能只是基于惯例认为自己暂时不需要更新马车。更深层次的,是大众对AI的落地有一些误解,表现为两种极端:一种极端是认为那是新潮前卫的重度用户、旗舰配置的事情,典型的场景是图像视频处理等;另一种极端是觉得是耳目一新的聊天机器人,类似于强化版的搜索引擎,有更好,无亦可。但实际上,AI PC的落地情况远超许多人的想象:对于商用客户而言,英特尔与全球超过100+个ISV深度优化合作,本土35+ISV在终端优化融合,创建包含300 多项ISV特性的庞大 AI生态系统,带来规模空前的AI PC体验!

而且,我并不认为这个数量级的AI应用落地是画饼或者“战未来”。因为在我眼里,诸多AI PC解决方案的展示,宛如“OpenVINO联欢会”。OpenVINO是英特尔开发的跨平台深度学习工具包,意即“开放式视觉推理和神经网络优化”。这个工具包其实在2018年就已经发布,数年来已经积累了大量计算视觉和深度学习推理应用,发展到Iris Xe核显时期,软件、硬件的配合就已经很有江湖地位了。譬如依托成熟的算法商店,基于11代酷睿平台可以很轻松的构建各式各样的AI应用,从智慧安防的行为检测,到店铺自动盘点,效果相当的好。现在,AI PC的核显进化到Xe-LPG,算力倍增,OpenVENO积累的各式应用本身就会有更好的表现,可以说“地利”(具有延续性的Xe引擎)和“人和”(OpenVINO的ISV资源)早就是现成的。

真正引爆AI PC的是“天时”,也就是大语言模型步入实用化。大语言模型的突破很好地解决了自然语言交互和数据训练的问题,极大地降低了普通用户利用AI算力的门槛。前面我举了很多嵌入办公应用的例子,在这里,我可以再举一个例子:科东智能控制器的多模态视觉语言模型与机械臂的结合。机械臂是司空见惯的机器人应用,早就可以结合机器视觉做各种操作,移动、分拣物品等等。但物品的识别和操作,传统上是是需要预训练和编程的。结合大语言模型后,整套系统就可以做多模态的指令识别与执行了,譬如我们可以说:把手机放到那张纸上面。在这个场景中,我们不再需要教会机器人手机是什么、纸是什么,不需要给具体的坐标,不需要规划移动的路径。自然语言的指令,摄像头的图像,这些多模态的输入被很好地融合,并自行生成了执行指令给机械臂。对于这样的工业场景,整套流程可以在一台笔记本电脑等级的算力平台上完成,数据不需要出厂。

所以,AI PC给我们带来的,绝对不仅仅是“更快的马车”,而是颠覆了PC的使用模式,拓展了用户的能力边界。盘点已有的ISV与解决方案,我们可以将AI PC的应用总结为六大场景:

●AlChatbot:针对特定行业和领域更加专业的问答。

●AIPC助理:直接对PC操作,处理个人文件、照片、视频等。

●AlOffice助手:Office插件,提升办公软件使用效率。

●AI本地知识库:RAG(Retrieval Augmented Generation,检索增强生成)应用,包括各类文本和视频文件。

●AI图像视频处理:图像、视频、音频等多媒体信息的生成与后期处理。

●AIPC管理:更加智能高效的设备资产及安全管理。

小结

基于酷睿Ultra的AI PC首先是更快、更强、更低功耗、更长待机的PC,这些硬件特性支撑的AI应用对我们的使用体验、使用模式带来了更深刻的改变。获得“智能涌现”加持的PC不再仅仅是生产力工具,在某些场景中,它直接可以化身协作者甚至操作者。这背后既有微架构和生产工艺提升带来的性能改进,也有大语言模型等新质生产力的赋能。

如果我们将CPU、GPU、NPU视作是AI PC的三大算力,相应的,也可以将AI PC让AI本地化(端侧)落地的价值归纳为三大法则:经济、物理、数据保密。所谓经济,是数据在本地处理可降低云服务成本,优化经济性;物理则对应云资源的“虚”,本地AI服务可以提供更好的及时性,更高的准确性,避免了云与端之间的传输瓶颈;数据保密,是指用户数据完全留在本地,防止滥用和泄露。

在2023年,大语言模型的狂飙成就了云端的AI元年。2024年,大语言模型的端侧落地开启了AI PC元年。我们也期待AI在云与端的交织发展当中不断夯实应用,源源不绝地释放强大生产力。(来源:益企研究院)

芯片头条

-

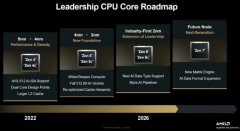

AMD发布 “领导力 CPU 核心路线图” 的 Zen 架构演进规划

2025-11-13 -

两部门发布首批计量支撑产业新质生产力发展“十大重点项目”

2025-11-13 -

三星电子美国工厂将为iPhone等苹果产品供应芯片

2025-08-07 -

全球首款2nm芯片!曝三星Exynos 2600多核成绩破万:超越高通骁龙8 Elite

2025-06-20 -

小米正在开发自己的玄戒 XRing 01 SoC,采用3nm 级工艺

2025-05-20